文章采集实例

通过采集腾讯新闻为例来说明采集器采集的原理和过程采集地址是:http://news.qq.com/newssh/shwx/shehuiwanxiang.htm

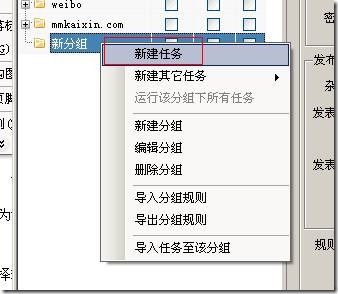

1,新建一个规则

右击任意分组,选择新建任务如下图:

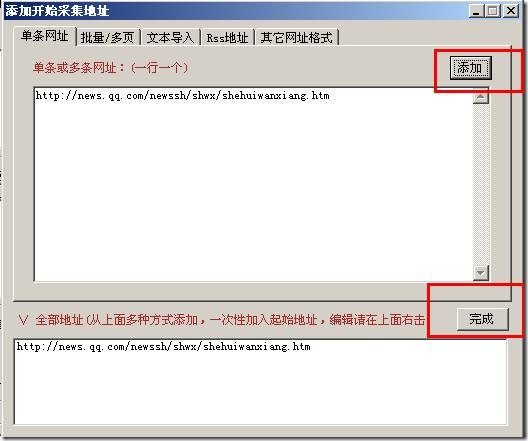

2,添加起始网址

所谓起始网址就是采集器采集网站的入口地址,一般就是文章的列表页地址如:http://news.qq.com/newssh/shwx/shehuiwanxiang.htm

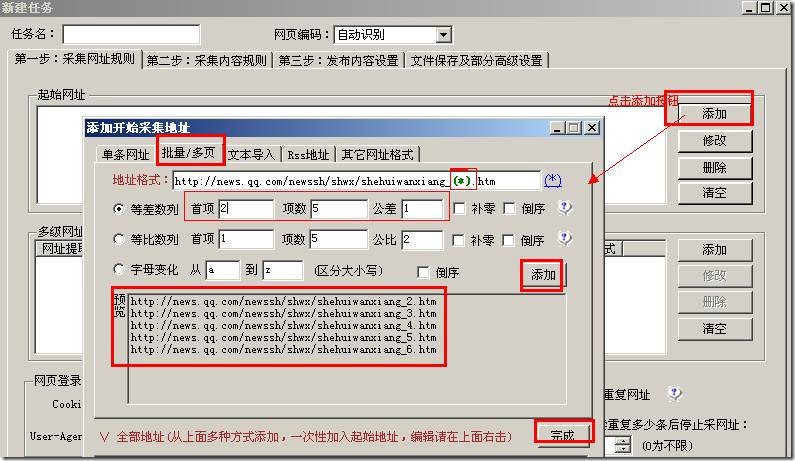

因为列表有分页。我们必须把分页也添加到采集器里面,我们先看下分页的规律。

第一页地址:http://news.qq.com/newssh/shwx/shehuiwanxiang.htm

第二页地址:http://news.qq.com/newssh/shwx/shehuiwanxiang_2.htm

第三页地址:http://news.qq.com/newssh/shwx/shehuiwanxiang_3.htm

由此我们可以推算出:

第n页地址:http://news.qq.com/newssh/shwx/shehuiwanxiang_n.htm

像这样有规律的分页如何在采集器里面添加如下图:

本例是用了等差数列。

上图看到我们用“(*)”代替变化的页码。

首项:是指开始的数字上面我们分析了页码是从“2”开始的;

项数:是指需要采集的页数

公差:相邻页码之间的数字差,读过书的人都知道公差是什么

预览:采集器会按照你上面设置的生成一部分网址,让你来判读添加的是否正确

如果正确就点击右边的“添加”按钮,然后再点击“完成”按钮。

下面还有等比数列,字母变化设置是一样的,就不在说了,大家都是读书人,不明白的话可以问下小学数学老师,教书育人的事情本教程就不做了。

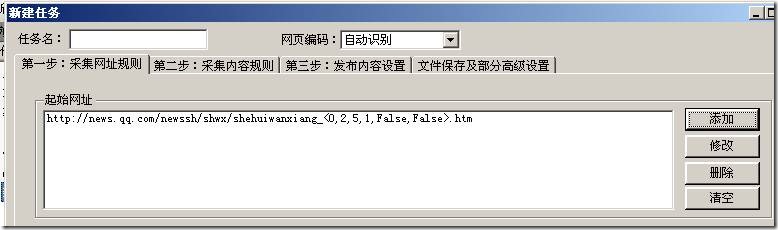

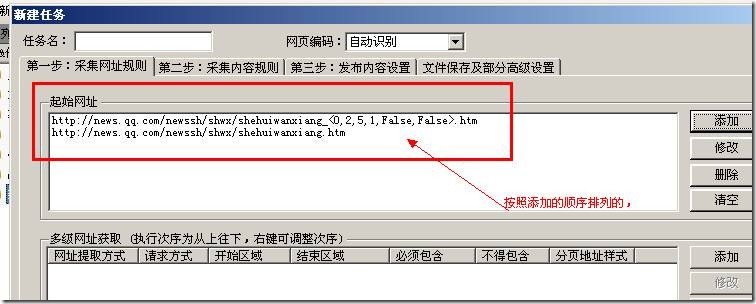

添加成功后:

到了这里,我们发现我们忘记添加第一页了,因为第一页和后面的页数规律不一样,不能在一起添加,必须单独添加如下图:

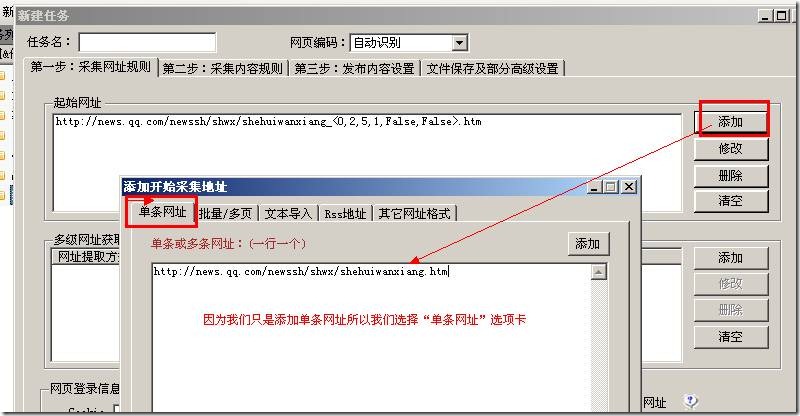

单条网址那里也是可以添加多条地址的一行一个

同样先点击“添加”按钮再点击“完成”按钮,就添加成功了:

多次添加起始网址是按照添加的顺序排列的,先添加的先采集后添加的后采集!!!!!

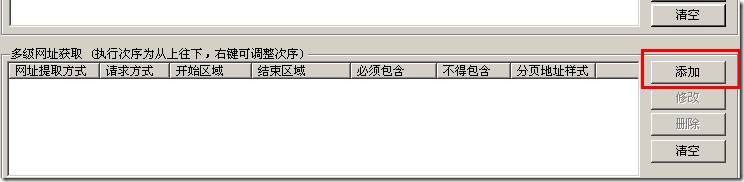

3,添加获取文章地址规则

上面我们已经添加了文章列表地址,现在需要通过文章列表页地址获取到最后的文章地址。

点击添加按钮:

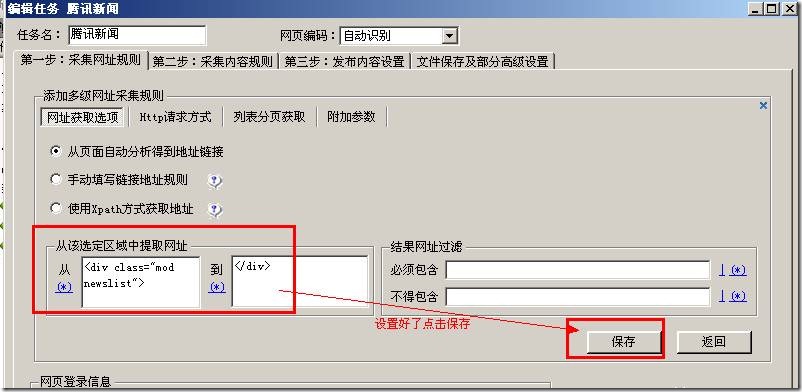

弹出下面界面:

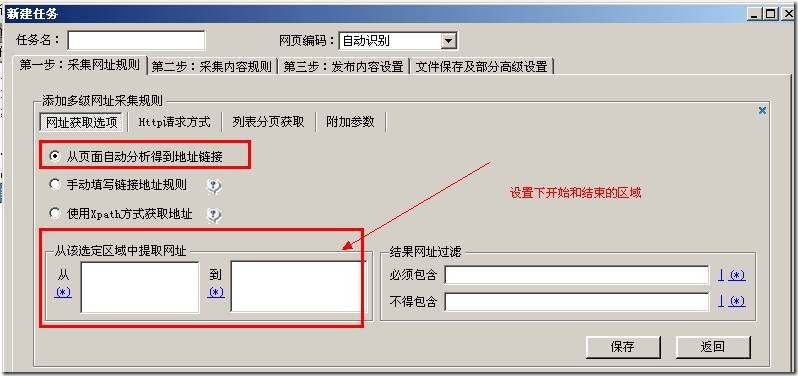

上图看到有很多的选项,本教程只讲解最简单的一种“从页面自动分析得到地址链接”,这种方式只要设置下面的开始结束区域,

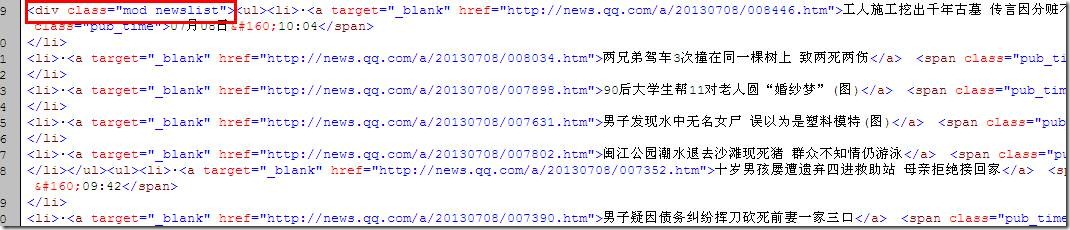

火车头就会自动获取到地址。查看页面源代码找到文章地址所在的区域

区域设置的大小是随意的只要能保证文章的地址刚好在这个区域里面,上图我找“<div class="mod newslist">”,要保证这个字符是在第一次出现

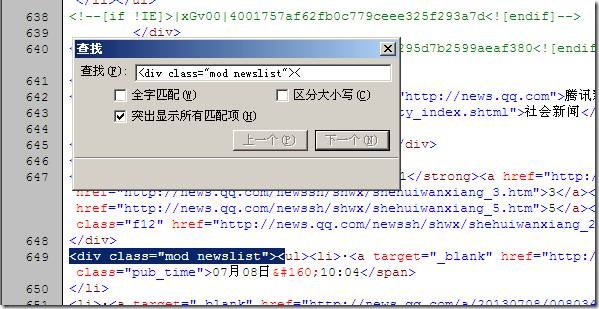

的地方刚好是文章列表地址开始的地方,所以我们找的字符可以是多次出现,我们只在意第一次出现的位置。通过查找结果如下:

刚好第一次出现的地方就是文章列表的开始,然后从这个字符串开始,我们一直找到最后一个文章地址的地方如下图:

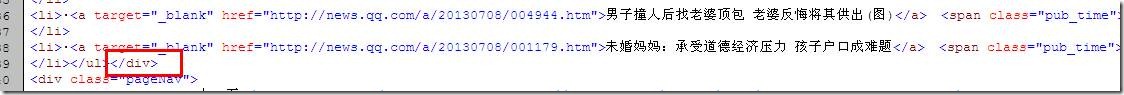

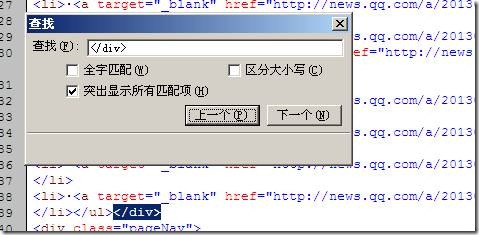

我们找到上图“</div>”,大家可以看到这个字符出现的次数不止一次为什么我们还是选择这个呢?从我们上面找到的开始

字符“<div class="mod newslist">”开始,保证我们找到的结束字符“</div>”是第一次出现的就可以了,我们查找下:

现在开始和结束字符都找到了我们填写到采集器里面如下图:

右侧“结果网址过滤”通过设置地址中必须包含和不得包含来排除些不要的信息多个条件之间用“|”隔开。

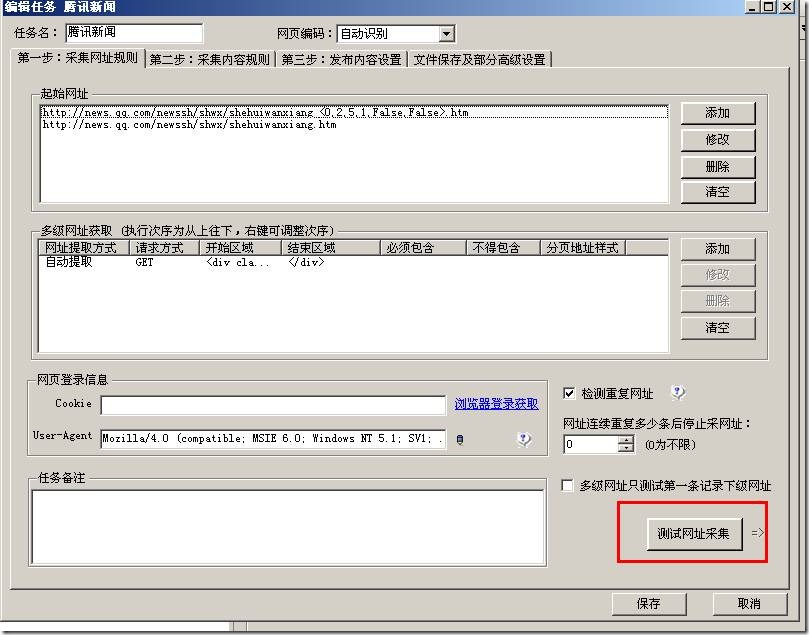

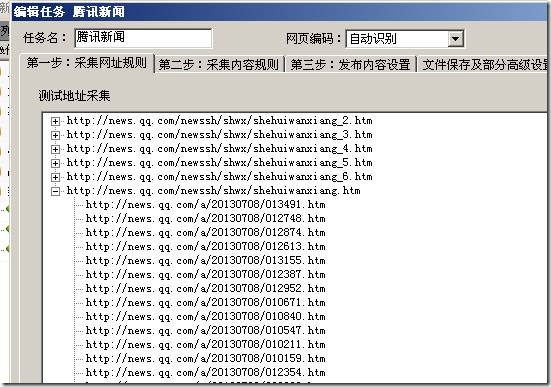

那么设置好了我们就可以测下采集结果:

结果如下:

已经成功采集了。

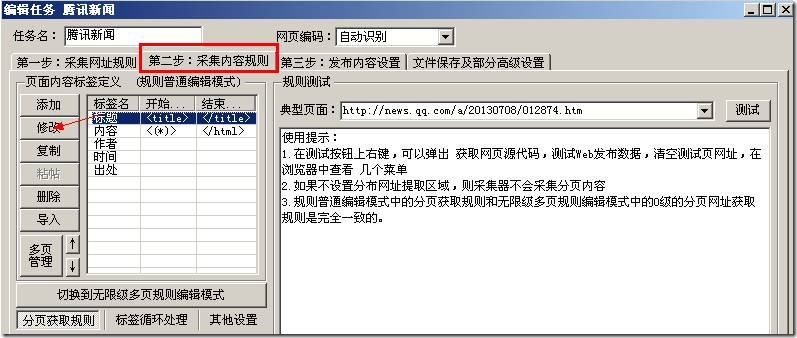

3,设置内容采集规则

通过采集地址:http://news.qq.com/a/20130708/012874.htm的标题内容来讲解如何采集我们需要的信息

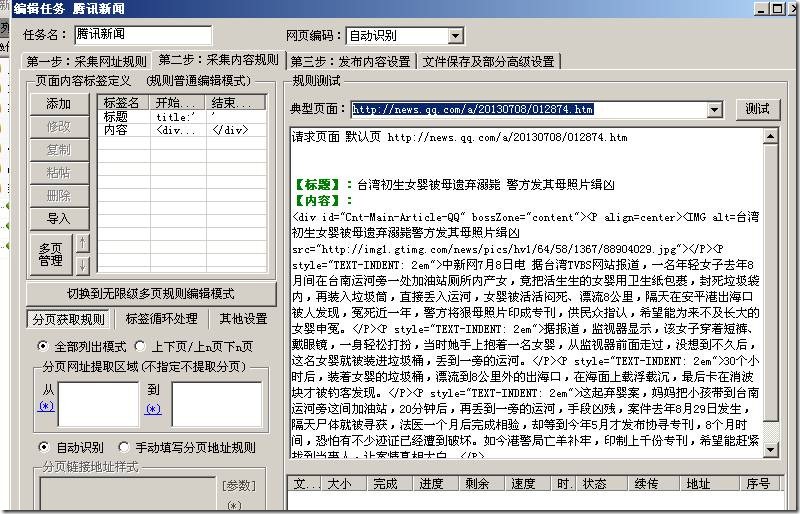

在第二步:采集内容规则选项卡,如下图:

这里已经建立好了标题,我们选中然后点击左侧的“修改”,来修改标签。

我们首先查看上面那个地址的页面源代码,找到我们“标题”在那里如下图:

我们找到很多处包含标题的地方,我们任意选择一个填写到采集器里面如下图:

看到了没有,我们只要找到标题前面字符是什么结束字符是什么,中间的就是我们要的内容。举个简单的例子:小王小李小陈站一排,

那么我知道小王在那里了,然后又知道小陈在那里了,那么夹杂他们中间的就是小李了。这里“小王”就是采集器里面说的“开始字

符串”,“小陈”就是采集器里面说的“结束字符串”,“小李”就是我们要“采集的内容”。

规则设置的原理就是这样的,理解了就简单了。就是找开始结束字符中间的就是我们要的,采集内容一样的道理设置,采集结果: